La tecnologia dell’IA restituisce la ‘voce’ a una donna con sindrome dell’incarcerazione post-ictus

AI technology gives voice to post-stroke locked-in syndrome woman

Condividi su Pinterest

Condividi su Pinterest- La sindrome del locked-in è un disturbo neurologico in cui una persona non può parlare o mostrare espressioni facciali.

- La maggior parte delle persone affette da questa condizione deve fare affidamento solo sul lampeggio degli occhi e sui movimenti per comunicare con gli altri.

- Ricercatori dell’Università della California, San Francisco, hanno sviluppato un nuovo modo per le persone con la sindrome del locked-in di comunicare e mostrare espressioni facciali attraverso l’uso di un impianto cerebrale e un avatar digitale.

La sindrome del locked-in è un disturbo neurologico che causa la paralisi dei muscoli volontari del viso, delle braccia e delle gambe di una persona.

Sebbene una persona con la sindrome del locked-in possa comprendere completamente ciò che qualcuno le sta dicendo o leggendo, non è in grado di parlare o mostrare emozioni attraverso il viso, come felicità, rabbia o tristezza.

Spesso, una persona con la sindrome del locked-in dipende da piccoli movimenti, come il battito delle palpebre, per comunicare con gli altri.

Ora, i ricercatori dell’Università della California, San Francisco, hanno sviluppato un nuovo modo per le persone con la sindrome del locked-in di comunicare e mostrare espressioni facciali attraverso l’uso di un impianto cerebrale e un avatar digitale.

Questo studio è stato recentemente pubblicato sulla rivista Nature.

- La FDA approva il primo biosimilare di natalizumab per il trattamen...

- Test di Ancestry del DNA e Consigli sulla Genealogia della Storia F...

- Le bevande energetiche Prime sono sicure per i bambini?

Cosa è la sindrome del locked-in?

La sindrome del locked-in è relativamente rara: meno di 1.000 persone negli Stati Uniti hanno questa condizione.

Di solito, la condizione è causata da un danno a una parte del tronco encefalico chiamata ponte, che provoca un blocco della funzione nervosa e la paralisi.

Il danno al tronco encefalico di solito si verifica durante un ictus, ma può anche verificarsi a causa di infiammazione dei nervi, tumori, infezioni o altre condizioni come la sclerosi laterale amiotrofica (SLA).

Quando una persona ha la sindrome del locked-in, perde la capacità di muovere i muscoli volontari a piacimento. Tuttavia, non perde alcuna capacità cognitiva, quindi è in grado di pensare normalmente e capire quando qualcuno le parla o legge. E l’udito non è influenzato.

Tuttavia, la sindrome del locked-in può influire sulla capacità di respirare e mangiare, influenzando la masticazione e la deglutizione.

Attualmente non esiste una cura o trattamenti specifici per la sindrome del locked-in. Un medico tratterà la causa sottostante della condizione e potrebbe prescrivere terapie fisiche e del linguaggio.

Comunicare con la sindrome del locked-in

Il modo più comune per le persone con la sindrome del locked-in di comunicare è attraverso i movimenti degli occhi e il battito delle palpebre.

Oggi esistono programmi informatici e altre tecnologie assistive che possono aiutarli a comunicare con gli altri, come le interfacce cervello-computer, i dispositivi a mouse per la testa e i sensori di movimento degli occhi a infrarossi.

E grazie alle innovazioni nell’ingegneria informatica e alle nuove tecnologie come l’intelligenza artificiale (AI), i ricercatori hanno presentato nuove opzioni di comunicazione per le persone con la sindrome del locked-in.

Ad esempio, uno studio pubblicato nel marzo 2022 ha mostrato che un uomo con la sindrome del locked-in è stato in grado di comunicare con la sua famiglia mediante l’uso di un impianto cerebrale e un’interfaccia per la scrittura.

Facilitare la ‘parola’ tramite l’AI

Per lo studio attuale, i ricercatori hanno sviluppato una nuova tecnologia cervello-computer utilizzando un impianto cerebrale e un avatar digitale. L’avatar digitale consente a una persona con paralisi facciale di esprimere espressioni facciali normali ed emozioni.

La nuova tecnologia è stata testata su una donna di 47 anni di nome Ann, che ha la sindrome del locked-in a seguito di un ictus del tronco encefalico.

Medical News Today ha parlato con il dott. David Moses, professore associato di neurochirurgia, parte del Chang Lab presso l’Università della California, San Francisco, e uno degli autori principali dello studio.

Secondo lui, quando parliamo, complessi pattern di attività cerebrale nel nostro corteccia motoria del linguaggio – la parte del cervello che coordina il nostro tratto vocale – vengono propagati attraverso un percorso neurale attraverso il tronco encefalico e infine ai nostri articolatori, come le labbra, la lingua, la laringe e la mandibola.

“Per Ann e per gli altri che hanno subito un ictus del tronco encefalico, questo percorso è danneggiato e i segnali dalla corteccia motoria del linguaggio non possono raggiungere i muscoli articolatori”, ha spiegato.

Con questo impianto cerebrale, ha dichiarato il dottor Moses, gli specialisti sono in grado di registrare l’attività neurale dalla corteccia mentre Ann cerca di parlare e traducono direttamente le sue parole intenzionate, bypassando completamente la sua paralisi.

Ha inoltre spiegato come funziona tutto ciò:

“Facciamo ciò creando innanzitutto modelli di intelligenza artificiale addestrati su dati neurali mentre cerca di dire in silenzio molte frasi: in realtà non pronuncia le parole ad alta voce, ma fa del suo meglio per “muovere” le parole all’interno delle frasi. Consentendo ai modelli di IA di apprendere la mappatura tra l’attività cerebrale e il discorso intenzionato, possiamo quindi utilizzare successivamente questi modelli in tempo reale per decodificare l’attività cerebrale in discorso. I modelli utilizzano rappresentazioni flessibili intermedie del discorso internamente, il che consente al decoder di produrre frasi che non ha cercato di dire durante l’addestramento”.

Dando ad Ann una “voce”

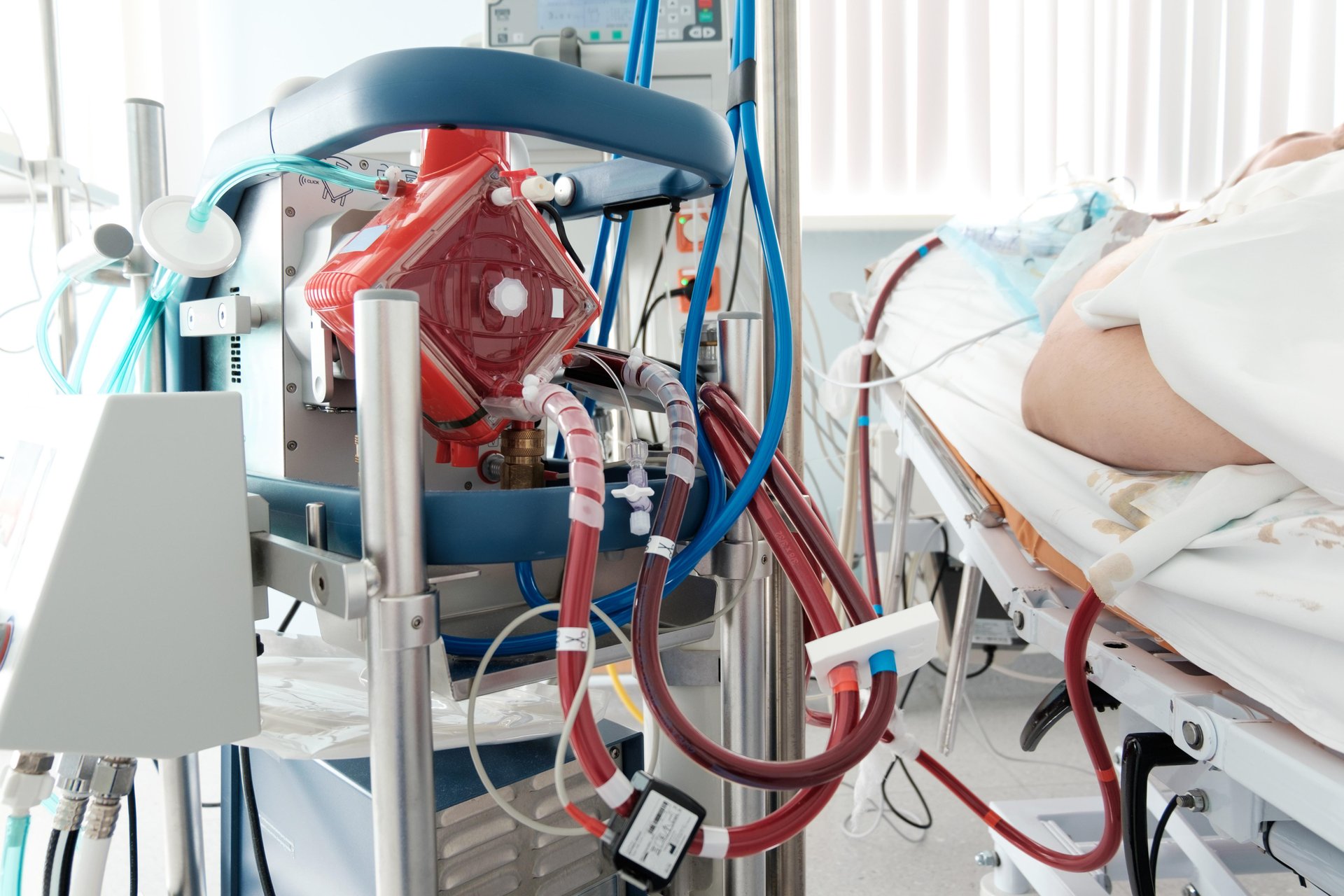

Ann ha ricevuto un impianto cerebrale con 253 elettrodi posizionati su specifiche aree superficiali del cervello cruciali per il linguaggio. Un cavo collega l’impianto cerebrale ai computer.

Per settimane, Ann ha lavorato con i ricercatori per addestrare gli algoritmi di intelligenza artificiale a riconoscere e rispondere ai suoi segnali cerebrali unici per il linguaggio.

I ricercatori hanno anche creato un avatar digitale di Ann attraverso un software che simula e anima i movimenti dei muscoli facciali.

Utilizzando l’apprendimento automatico, sono stati in grado di collegare il software ai segnali provenienti dal cervello di Ann e convertirli in movimenti sul viso del suo avatar, mostrando sia il linguaggio che le espressioni facciali.

Inoltre, gli scienziati sono stati in grado di utilizzare riprese da un video precedente all’infortunio per ricreare la voce effettiva di Ann. In questo modo, quando parla attraverso l’avatar digitale, è la sua voce e non una voce computerizzata predefinita.

Prossimi passi nella ricerca

Quando gli è stato chiesto quali sarebbero stati i prossimi passi in questa nuova tecnologia, il dottor Moses ha detto che ci sono molte possibilità di miglioramento.

“Per l’hardware, è necessaria una versione wireless per migliorare la fattibilità come soluzione clinica”, ha osservato.

“Per quanto riguarda il software, vogliamo integrare le nostre soluzioni con i dispositivi esistenti di Ann, in modo che possa utilizzare il sistema per scrivere e navigare in rete. Vogliamo anche sfruttare i progressi nella modellazione AI generativa per migliorare le nostre traduzioni”, ha aggiunto il dottor Moses.

Risolvere una questione difficile

MNT ha anche parlato di questo studio con il dottor Amit Kochhar, specializzato in otorinolaringoiatria, chirurgia della testa e del collo e chirurgia plastica ricostruttiva facciale, nonché direttore del Programma per i disturbi del nervo facciale presso il Pacific Neuroscience Institute di Santa Monica, California, che non è stato coinvolto nella ricerca.

Come medico che cura pazienti con paralisi facciale, ha detto che una delle cose più difficili per i pazienti è l’incapacità di esprimere le proprie emozioni agli altri.

“La ricerca ha dimostrato che se un osservatore comune guarda una persona che ha metà del viso paralizzato, non riesce a discriminare se la persona sta comunicando un’emozione felice o arrabbiata”, ha spiegato il dottor Kochhar. “E quindi c’è molta confusione da parte dell’osservatore e ovviamente frustrazione da parte del paziente”.

“E quindi se avessero accesso a qualcosa del genere, […] potrebbero comunque comunicare con gli altri, come i membri della famiglia, gli amici, utilizzando questa tecnologia di avatar in modo da poter trasmettere correttamente le emozioni di felicità, sorpresa o rabbia senza avere quella confusione”, ha aggiunto.

Il dottor Kochhar ha detto che vorrebbe vedere questa tecnologia utilizzata da più persone per assicurarsi che sia riproducibile ed economica.

“Se il costo di questo dispositivo e se è disponibile solo per una piccola percentuale della popolazione che può permetterselo, è sicuramente un grande progresso, ma non aiuterà molte altre persone”, ha aggiunto.

Il dottor Kochhar ha anche detto che vorrebbe vedere questa tecnologia resa portatile: “Il paziente doveva recarsi al centro per farlo funzionare, non era in grado, al momento, di portarlo a casa. E quindi questi sono i prossimi passi dell’evoluzione di questo tipo di software”.